Las GPUs NVIDIA H100 Hopper establecieron récords mundiales, mientras que las A100 mostraron liderazgo en el rendimiento general y los Jetson AGX Orin lideraron en computación perimetral.

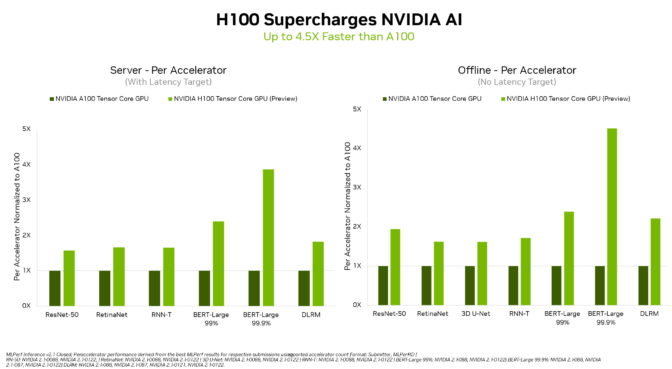

En su debut en los puntos de referencia de IA estándar de la industria de MLPerf*, las GPUs NVIDIA H100 Tensor Core establecieron récords mundiales en inferencia en todas las cargas de trabajo, brindando hasta 4,4 veces más rendimiento que las GPUs de la generación anterior.

El H100, también conocido como Hopper, elevó el listón en el rendimiento por acelerador en las seis redes neuronales de la ronda. Demostró liderazgo tanto en rendimiento como en velocidad en escenarios separados de servidores y offline.

La arquitectura NVIDIA Hopper entregó hasta 4,5 veces más rendimiento que las GPU de arquitectura NVIDIA Ampere, que continúan brindando liderazgo general en los resultados de MLPerf.

Hopper se destacó en el popular modelo BERT para el procesamiento del lenguaje natural. Se encuentra entre los modelos de IA de MLPerf más grandes y con más rendimiento.

Estos puntos de referencia de inferencia marcan la primera demostración pública de las GPU H100, que estarán disponibles a finales de este año. Las GPU H100 participarán en futuras rondas de capacitación de MLPerf.

Las GPU A100 muestran liderazgo

Las GPU NVIDIA A100, por su parte, continuaron mostrando un liderazgo general en el rendimiento general de la inferencia de IA en las últimas pruebas.

Las GPU A100 ganaron más pruebas que cualquier presentación en las categorías y escenarios de centro de datos y computación perimetral. En junio , el A100 también logró el liderazgo general en los puntos de referencia de capacitación de MLPerf, demostrando sus habilidades en todo el flujo de trabajo de IA.

Desde su debut en julio de 2020 en MLPerf, las GPU A100 han multiplicado por 6 su rendimiento, gracias a las mejoras continuas en el software NVIDIA AI.

NVIDIA AI es la única plataforma que ejecuta todas las cargas de trabajo y escenarios de inferencia de MLPerf en el centro de datos y la computación perimetral.

Los usuarios necesitan un rendimiento versátil

La capacidad de las GPU NVIDIA para ofrecer un rendimiento de liderazgo en todos los principales modelos de IA hace que los usuarios sean los verdaderos ganadores. Sus aplicaciones del mundo real suelen emplear muchas redes neuronales de diferentes tipos.

Por ejemplo, una aplicación de IA puede necesitar comprender la solicitud hablada de un usuario, clasificar una imagen, hacer una recomendación y luego entregar una respuesta como un mensaje hablado con una voz que suena humana. Cada paso requiere un tipo diferente de modelo de IA.

Los puntos de referencia de MLPerf cubren estas y otras cargas de trabajo y escenarios populares de IA: visión por computadora, procesamiento de lenguaje natural, sistemas de recomendación, reconocimiento de voz y más. Las pruebas aseguran que los usuarios obtendrán un rendimiento confiable y flexible para implementar.

Los usuarios confían en los resultados de MLPerf para tomar decisiones de compra informadas, porque las pruebas son transparentes y objetivas. Los puntos de referencia cuentan con el respaldo de un amplio grupo que incluye a Amazon, Arm, Baidu, Google, Harvard, Intel, Meta, Microsoft, Stanford y la Universidad de Toronto.

Orin lidera en el borde

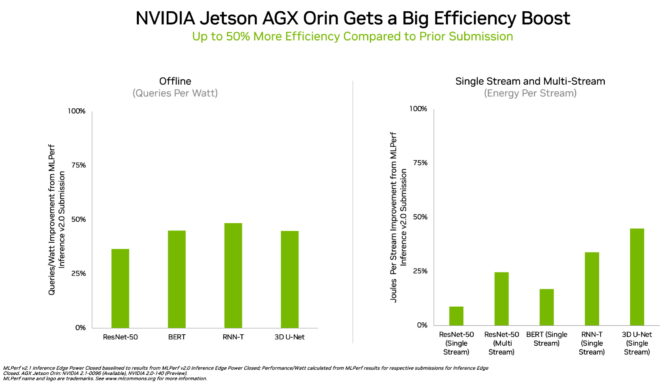

En la computación perimetral, NVIDIA Orin ejecutó todos los puntos de referencia de MLPerf y ganó más pruebas que cualquier otro sistema en un chip de bajo consumo. Y mostró una ganancia del 50 % en eficiencia energética en comparación con su debut en MLPerf en abril.

En la ronda anterior, Orin funcionó hasta 5 veces más rápido que el módulo Jetson AGX Xavier de la generación anterior, mientras ofrecía un promedio de 2 veces más eficiencia energética.

Orin integra en un solo chip una GPU de arquitectura NVIDIA Ampere y un grupo de potentes núcleos de CPU Arm. Está disponible hoy en el kit para desarrolladores NVIDIA Jetson AGX Orin y en los módulos de producción para robótica y sistemas autónomos, y es compatible con la pila completa de software NVIDIA AI, incluidas las plataformas para vehículos autónomos (NVIDIA Hyperion), dispositivos médicos (Clara Holoscan) y robótica (Isaac)…

Amplio ecosistema de IA de NVIDIA

Los resultados de MLPerf muestran que NVIDIA AI está respaldada por el ecosistema de aprendizaje automático más amplio de la industria.

Más de 70 presentaciones en esta ronda se realizaron en la plataforma NVIDIA. Por ejemplo, Microsoft Azure envió resultados ejecutando NVIDIA AI en sus servicios en la nube.

Su trabajo muestra que los usuarios pueden obtener un gran rendimiento con NVIDIA AI tanto en la nube como en servidores que se ejecutan en sus propios centros de datos.

Los partners de NVIDIA participan en MLPerf porque saben que es una herramienta valiosa para los clientes que evalúan proveedores y plataformas de IA. Los resultados de la última ronda demuestran que el rendimiento que ofrecen a los usuarios hoy en día crecerá con la plataforma NVIDIA.

Todo el software utilizado para estas pruebas está disponible en el repositorio de MLPerf, por lo que cualquiera puede obtener estos resultados de clase mundial. Las optimizaciones se pliegan continuamente en contenedores disponibles en NGC , el catálogo de NVIDIA para software acelerado por GPU. Ahí es donde también encontrará NVIDIA TensorRT , utilizado por cada presentación en esta ronda para optimizar la inferencia de IA.

Solicitar más información

*El MLPerf es un consorcio de líderes de Inteligencia Artificial académicos, de laboratorios de investigación e industria cuya misión es construir puntos de referencia justos y útiles que proporcionan evaluaciones imparciales del rendimiento de la capacitación e inferencia para hardware, software y servicios, todo realizado bajo condiciones prescritas.