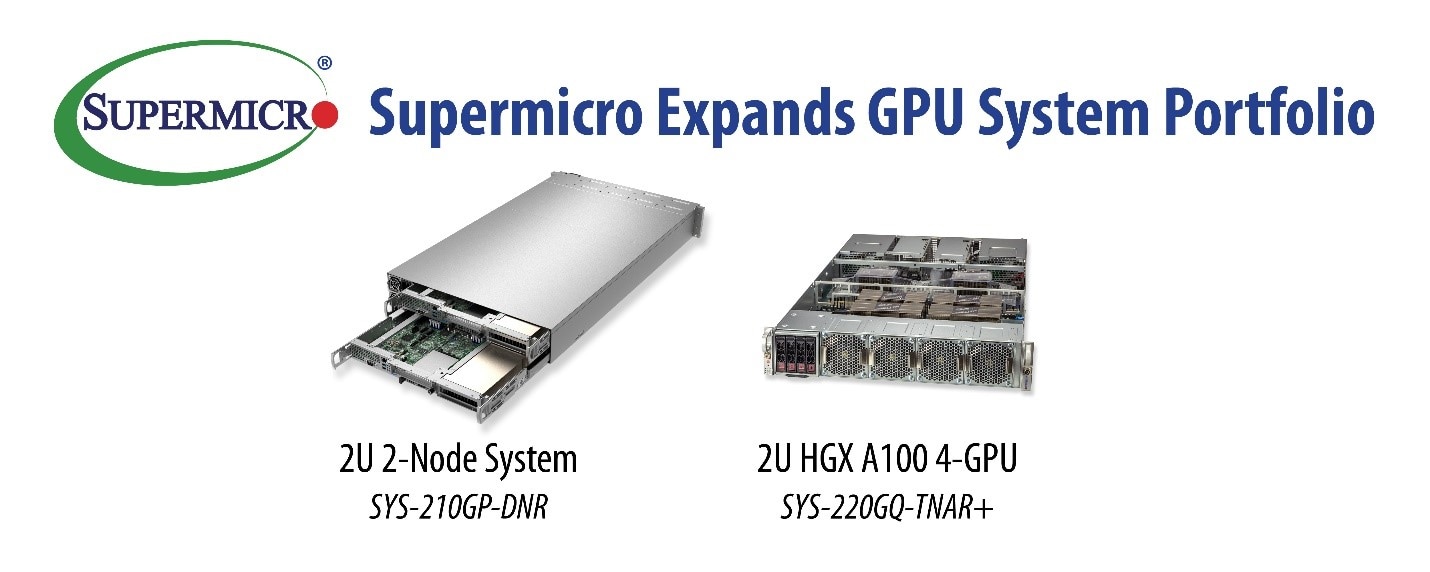

Supermicro anuncia nuevos sistemas basados den GPU con arquitectura NVIDIA Ampere y procesadores escalables Intel Xeon de Tercera Generación con aceleradores de IA integrados.

Estos servidores están diseñados para aplicaciones de inteligencia artificial exigentes donde la baja latencia y el alto rendimiento de las aplicaciones son esenciales. El sistema 2U NVIDIA HGX ™ A100 4-GPU es adecuado para implementar clústeres de entrenamiento de IA modernos a escala con interconexión de alta velocidad CPU-GPU y GPU-GPU. El sistema Supermicro 2U 2-Node reduce el uso de energía y los costos al compartir fuentes de alimentación y ventiladores de enfriamiento, reduciendo las emisiones de carbono y admite una gama de aceleradores de GPU discretos, que se pueden adaptar a la carga de trabajo.

“Los ingenieros de Supermicro han creado otra amplia cartera de sistemas basados en GPU de alto rendimiento que reducen los costos, el espacio y el consumo de energía en comparación con otros diseños en el mercado”, dijo Charles Liang, presidente y director ejecutivo de Supermicro. “Con nuestro diseño innovador, podemos ofrecer a los clientes NVIDIA HGX A100 (nombre en clave Redstone) 4-GPU aceleradores para cargas de trabajo de IA y HPC en formatos densos de 2U. Además, nuestro sistema 2U de 2 nodos está diseñado exclusivamente para compartir componentes de energía y refrigeración que reducen el OPEX y el impacto en el medio ambiente “.

El servidor 2U NVIDIA HGX A100 se basa en los procesadores escalables Intel Xeon de tercera generación con tecnología Intel Deep Learning Boost y está optimizado para cargas de trabajo de análisis, capacitación e inferencia. El sistema puede ofrecer hasta 2,5 petaflops de rendimiento de inteligencia artificial, con cuatro GPU A100 completamente interconectadas con NVIDIA NVLink®, que proporcionan hasta 320 GB de memoria GPU para acelerar los avances en ciencia de datos empresariales e inteligencia artificial. El sistema es hasta 4 veces más rápido que las GPU de la generación anterior para modelos de IA conversacionales complejos como la inferencia grande de BERT y ofrece un aumento de rendimiento hasta 3 veces mayor para el entrenamiento de IA grande de BERT.

Además, los diseños térmicos y de refrigeración avanzados hacen que estos sistemas sean ideales para clústeres de alto rendimiento donde la densidad de nodos y la eficiencia energética son prioridades. La refrigeración líquida también está disponible para estos sistemas, lo que resulta en aún más ahorros OPEX. La memoria persistente Intel Optane ™ (PMem) también es compatible con esta plataforma, lo que permite almacenar modelos significativamente más grandes en la memoria, cerca de la CPU, antes de procesarlos en las GPU. Para aplicaciones que requieren interacción de múltiples sistemas, el sistema también puede equiparse con cuatro tarjetas InfiniBand NVIDIA ConnectX®-6 de 200 Gb / s para admitir GPUDirect RDMA con una relación de GPU a DPU de 1: 1.

El nuevo 2U 2-Node es una arquitectura de ahorro de recursos energéticamente eficiente diseñada para que cada nodo admita hasta tres GPU de doble ancho. Cada nodo también cuenta con un único procesador escalable Intel Xeon de tercera generación con hasta 40 núcleos y aceleración de IA y HPC incorporada. Una amplia gama de aplicaciones de IA, renderizado y VDI se beneficiarán de este equilibrio de CPU y GPU. Equipado con ranuras de expansión de módulo de E / S avanzado (AIOM) de Supermicro para capacidades de red rápidas y flexibles, el sistema también puede procesar un flujo de datos masivo para aplicaciones exigentes de AI / ML, entrenamiento de aprendizaje profundo e inferencias mientras asegura la carga de trabajo y los modelos de aprendizaje. También es ideal para juegos en la nube de alta gama de múltiples instancias y muchas otras aplicaciones de VDI con uso intensivo de cómputo. Además, Las redes de entrega de contenido virtual (vCDN) podrán satisfacer la creciente demanda de servicios de transmisión. La redundancia de la fuente de alimentación está incorporada, ya que cualquiera de los nodos puede utilizar la fuente de alimentación del nodo adyacente en caso de una falla.